Mistral AI, la start-up française devenue licorne, a lancé son nouveau modèle de langage Mixtral 8x7B, basé sur l'approche « Mixture of Experts ». Ce modèle multilingue surpasse Llama 2 70B et GPT-3.5 sur de nombreux benchmarks, offrant des performances rapides et une gestion optimisée des ressources.

La start-up française Mistral AI, récemment devenue une licorne après avoir levé 385 millions d'euros, a annoncé le lancement de son nouveau modèle de langage, Mixtral 8x7B. Ce modèle, conçu selon l’approche « Mixture of Experts », promet des performances impressionnantes.

Une valorisation impressionnante et un modèle de pointe

Quelques semaines après avoir dévoilé son premier grand modèle de langage, Mistral AI devient officiellement une licorne avec une valorisation de 1,86 milliard d'euros. Le nouveau modèle, Mixtral 8x7B, serait selon Mistral le plus puissant modèle de langage ouvert à ce jour. Il surpasserait Llama 2 70B sur de nombreux benchmarks, avec des capacités d’inférence six fois plus rapides. En outre, il égalerait ou surpasserait GPT-3.5 sur plusieurs critères.

Mixtral est un modèle multilingue capable de comprendre l'anglais, le français, l'italien, l'allemand et l’espagnol. Il excelle également en programmation et peut traiter une fenêtre de contexte de 32 000 tokens (environ 25 000 mots), comparable à GPT-4.

L’approche « Mixture of Experts » (MOE)

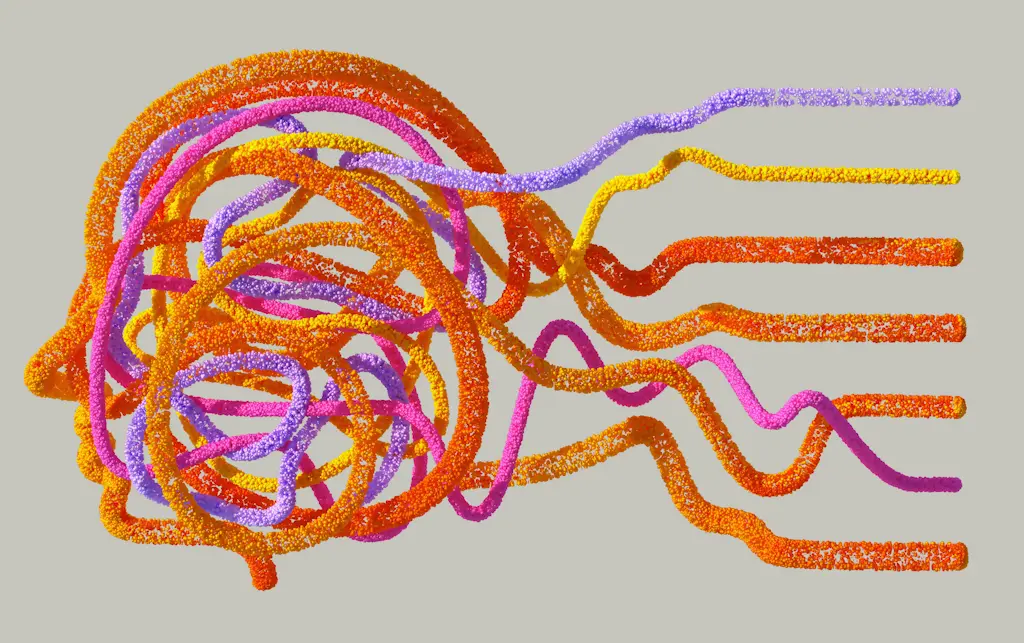

Le modèle Mixtral repose sur l’approche « Mixture of Experts » (MOE), qui permet d'augmenter le nombre de paramètres tout en contrôlant le coût et la latence. Ce modèle comprend 46,7 milliards de paramètres, mais n’en utilise que 12,9 milliards par token, ce qui optimise les ressources.

Dans une architecture MOE, des réseaux neuronaux distincts appelés « experts » traitent des sous-ensembles spécifiques des données d'apprentissage. Un réseau de passerelles orchestre la distribution des tokens vers les experts les plus pertinents pour chaque tâche. Ce système permet un pré-entraînement beaucoup plus efficace en termes de calculs, tout en offrant une inférence plus rapide que d'autres modèles de même taille.

Une innovation prometteuse pour l’IA

Mistral AI continue de se démarquer dans l'univers des start-ups IA avec un modèle qui réinvente la gestion des ressources tout en augmentant les performances. Mixtral est une étape importante dans l’évolution des modèles de langage et promet de révolutionner les usages de l’intelligence artificielle.

Source : ICTJournal